深層学習でドット絵のような荒い写真を高画質化できるプログラムがGitHubに公開

David Garcia氏が開発した、非常に荒い解像度の写真を深層学習(ディープラーニング)を用いて高画質化するプログラムがGitHubで公開されている。

記事によると

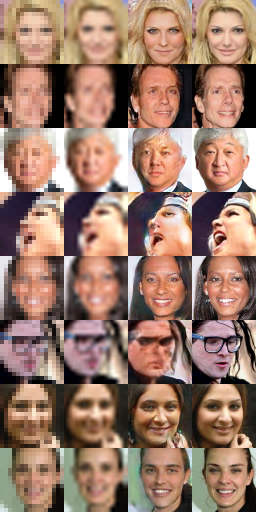

・ソフトウェアエンジニアのDavid Garcia氏が、解像度の低い画像を、深層学習(ディープラーニング)を用いて高画質化するプログラム「srez」をGitHubで公開した

・このプログラムは16×16ドットの低画質画像を、縦横4倍の64×64ドットの高画質画像に出力する

・ただし、顔が正面を向いていなかったり、眼鏡をかけた顔などについてはまだ改善の余地があり、画質が低かったり歪んだりしている

・この結果はGeForce GTX 1080を使って3時間かけて出力したもの

・ソフトウェアエンジニアのDavid Garcia氏が、解像度の低い画像を、深層学習(ディープラーニング)を用いて高画質化するプログラム「srez」をGitHubで公開した

・このプログラムは16×16ドットの低画質画像を、縦横4倍の64×64ドットの高画質画像に出力する

・ただし、顔が正面を向いていなかったり、眼鏡をかけた顔などについてはまだ改善の余地があり、画質が低かったり歪んだりしている

・この結果はGeForce GTX 1080を使って3時間かけて出力したもの

プログラムのダウンロードはこちらから↓

この記事への反応

1. この話題に反応する名無しさん

スパイものや刑事もののドラマや映画でよく見るアレが、もうすぐ再現できるようになるのか…

2. この話題に反応する名無しさん

昔のPCゲーム的なドット絵を読み込ませてみたい

3. この話題に反応する名無しさん

これ凄い、と思うと同時に思い出すモザイク除去機。

4. この話題に反応する名無しさん

なんか、昔映画とかであり得ない画像解析と思ってみていたものが、現実味を帯びてきた。

5. この話題に反応する名無しさん

精度にばらつきあるけど、こういうことができるのかと驚いた。

6. この話題に反応する名無しさん

これまた使い方が問われるもん作りやがって…

7. この話題に反応する名無しさん

また未来が来た

ディープラーニング、深層学習(英: deep learning)とは、多層構造のニューラルネットワーク(ディープニューラルネットワーク、英: deep neural network)を用いた機械学習である。莫大な計算資源を用意し、ニューラルネットワークの規模を拡大することが必要だが、汎用的なAI、いわゆる強いAIの実現が期待されている。概念・手法は1980年前後からあったが、2010年代に画像認識などから急速に盛り上がり、三度目の人工知能ブームと言われる。第三次ブーム以後は、機械学習は単なる流行を超えて社会インフラとして広く定着して行った。現在は未だに特化型のAIのみが実用化されている段階にある。コグニティブコンピューティングの核となる技術でもある。

概要

ディープラーニングは、ニューラルネットワークの多層化、特に3層以上のものに対し、1990年代に進められた脳、特に視覚野の研究や、「たった一つの学習理論(英語: One Learning Theory)」、ブルーノ・オルスホーゼンによるスパース・コーディング理論を基にしたアルゴリズムが実装されたものを指す。

これに画像などのデータを入力すると、情報が第1層からより深くへ伝達されるうちに、各層で学習が繰り返される。この過程で、これまでは画像や音声などそれぞれのデータの研究者、技術者が手動で設定していた特徴量が自動で計算される。

特徴量とは、問題の解決に必要な本質的な変数であったり、特定の概念を特徴づける変数である。この特徴量を発見できれば、あらゆる問題の解決につながったり、パターン認識精度の向上や、フレーム問題の解決につながったりすると期待されている。この階層的な特徴量の学習が、ディープラーニングが従来の機械学習と決定的に異なる点である。

この技術は、画像認識や音声認識等の分野に活用される。2012年には、Googleの開発したグーグル・ブレインが、猫の概念を学習することに成功した。

GTX1080で3時間・・・

まだまだ課題は多いけど夢のあるプログラムですな

新海誠監督作品 君の名は。 公式ビジュアルガイド

posted with amazlet at 16.08.31

新海 誠

KADOKAWA/角川書店 (2016-08-27)

売り上げランキング: 3

KADOKAWA/角川書店 (2016-08-27)

売り上げランキング: 3

深層畳み込みニューラルネットワークによる二次元画像のための超解像システムじゃないか!

こういうわかりやすい結果で見せてくれるとだいぶ身近に感じるな

とりあえずディスプレイが高繊細化しすぎて解像度の足りない壁紙をなんとかしてくれ

また別問題か

ラーニングさせる内容次第

ひ ら め い た

ところどころ逆にしてない?

ああそういうことか

ただのモザイク画像から正解導き出すだけのツールなんか

人と同じで予測が可能な知識が無いと補正出来ないということか。

監視カメラの画像解析とか限られた用途しかないけど、

需要は確実にありそうな技術だね。

完全に除去できてしまうソフトが悪いんですという言い逃れ

付けられるならこう言う技術の導入も考えて欲しいなポリスメン

そして公共の場にはドンドン監視カメラを導入しよう、困るのは犯罪者のみですよ!

希に陰謀に巻き込まれる事はあるかもしれませんがw

こりゃ30年後もたいして変わらんな

モザイクかける前の画像を大量に集めて学習させる必要があるけど

原理的には可能だと思う

無能警察がプログラムをわいせつ物と判定して逮捕するんだろw

無理

全然違うじゃねえか

「様々な画像を参考にさせて人工知能にそれらしく作画させてる」ってものみたいだね

文字が読めるようになるのは無理かな?

でもこれ動画が対象ならかなり精度上がりそうね

ディープラーニングって要するに

膨大なサンプルの中から正解と思われる形を拾って来るだけだけだからね

まあそれが凄いんだけど

元の絵とは同じにはならないよね

もっと綺麗にしたりとかもできそう

無い情報をどうやって付け足すのか不明

その逆を類推する感じかな

だから眼鏡かけてるだけで完全に破たんすると

そうだぞパソコンに籠るのをやめて家のゴミの汚名を返上しとけよ

平たく言えばコンピューターなりの経験則

だから間違ってることもある

いつかこれがリアルタイムで出来る様になって日本のAV(ry

まったく同じ原理だぞ

だからディープラーニングゆーてるやん。

でもお前がスーパーディープラーニングするのが先。

今回のアプリは16×16の固定サイズなのがダメだなぁ。

モザイクが消える〜

これじゃ実用的になるのは20年後かな

サンプルの画像がそもそもこれ使って生成されたものとは思えない

画像見る限りではそうだね

しかしこうして見るとプログラムで導き出された画像と元画像にはかなりの隔たりがあるな

まぁあくまで予測画像だからこんなもんか

これなら最新の超解像技術の方が明らかに上だな

3枚目までいっちゃうとかえって実物と比べてコレジャナイ感が出る。

って感じやね、おかけでサンプル画像の一部は酷いことになってる。

まず試してみたらいいのに

GTX1080持ってないの??

gpuで処理してないじゃn

用途が限られすぎて。

全部一番右が元画像でしょ

さて、「リアルタイムハイデフィニショニング」が実用になるのはいつ?いずれ昔の映画や記録フィルムが簡単作業で鮮明高画質化できるようになるってことだ

GPGPUって知らないのか?

大量のコア使って並列計算するんだよ

マスを動かしてる場合もあるからこのソフト使っても元には戻らないよ

実際の顔は一番右側が似てるであってんのかな。

これはひどい

テスラとか知らなさそう

実用性が思い浮かばないなw

まあ、モンタージュだって似顔絵だって正解じゃないからそれでいいんだろうけど。

AVのモザイク除去方面にはクッソ実用的だと思う

あれは別に正解である必要は無いわけだからな

やっぱ専門知識ないと無理か

……これ、Waifu2xみたいな技術と違うん?